Was ein Zollstock über neuronale Netzwerke verrät

Forschende der Universität Basel haben mechanische Modelle entwickelt, die vorhersagen können, wie effektiv die verschiedenen Schichten eines tiefen neuronalen Netzwerks Daten verarbeiten. Ihre Ergebnisse verbessern unser Verständnis dieser komplexen Systeme und ermöglichen bessere Strategien für das Training neuronaler Netzwerke.

10. Juli 2025 | Oliver Morsch

Tiefe neuronale Netzwerke sind das Herzstück der künstlichen Intelligenz, von der Mustererkennung bis hin zu grossen Sprach- und Reasoning-Modellen wie ChatGPT. Das Grundprinzip: Die Einstellungen der künstlichen Neuronen des Netzwerks werden während einer Trainingsphase so optimiert, dass sie bestimmte Aufgaben ausführen können, wie zum Beispiel auf Bildern eigenständig Objekte oder charakteristische Merkmale («Features») zu entdecken.

Wie genau das funktioniert, und warum manche neuronalen Netzwerke leistungsfähiger sind als andere, ist nicht leicht zu verstehen. Eine rigorose mathematische Beschreibung scheint mit gängigen Methoden unerreichbar zu sein. Andererseits ist ein solches Verständnis aber wichtig, wenn man künstliche Intelligenz mit möglichst geringem Ressourcenaufwand konstruieren möchte.

Forschende um Prof. Dr. Ivan Dokmanić von Departement Mathematik und Informatik der Universität Basel haben nun ein verblüffend einfaches Modell entwickelt, das die wesentlichen Eigenschaften von tiefen neuronalen Netzwerken nachbildet und es erlaubt, deren Parameter zu optimieren. Ihre Ergebnisse haben sie kürzlich im Fachjournal «Physical Review Letters» veröffentlicht.

Arbeitsteilung im neuronalen Netzwerk

Tiefe neuronale Netzwerke bestehen aus mehreren Schichten von Neuronen. Wenn ein Netzwerk lernt, Objekte in Bildern zu klassifizieren, so nähert es sich Schicht für Schicht der Antwort. Diese stufenweise Annäherung, während der zwei Klassen – etwa «Hund» und «Katze» – immer deutlicher unterschieden werden, bezeichnet man als Datenseparation. «In gut funktionierenden Netzwerken trägt normalerweise jede Schicht gleichermassen zur Datenseparation bei, aber manchmal wird die meiste Arbeit von den oberflächlichen oder von den tiefen Schichten gemacht», sagt Dokmanić.

Das hängt unter anderem davon ab, wie das Netzwerk aufgebaut ist: Multiplizieren die Neuronen eingehende Daten einfach mit einem bestimmten Faktor, was Fachleute als «linear» bezeichnen würden? Oder führen sie kompliziertere Rechnungen aus, ist das Netzwerk also «nichtlinear»? Ein weiterer Aspekt: Die Trainingsphase von tiefen neuronalen Netzwerken enthält meist auch ein Zufallselement oder Rauschen. So kann zum Beispiel in jeder Trainingsrunde ein zufällig ausgewählter Teil der Neuronen unabhängig von deren Eingangsdaten einfach ignoriert werden. Kurioserweise kann dieses Daten-Rauschen die Leistung des Netzwerks verbessern.

«Das Zusammenspiel von Nichtlinearität und Rauschen führt zu sehr komplexem Verhalten, das schwer zu verstehen und vorherzusagen ist», sagt Dokmanić. «Anderseits weiss man, dass eine gleichmässige Verteilung der Datenseparation zwischen den Schichten Netzwerke leistungsfähiger macht.» Um weiterzukommen liessen Dokmanić und seine Mitarbeitenden sich von physikalischen Theorien inspirieren und entwickelten mechanische Modelle des Lernprozesses, die man intuitiv verstehen kann.

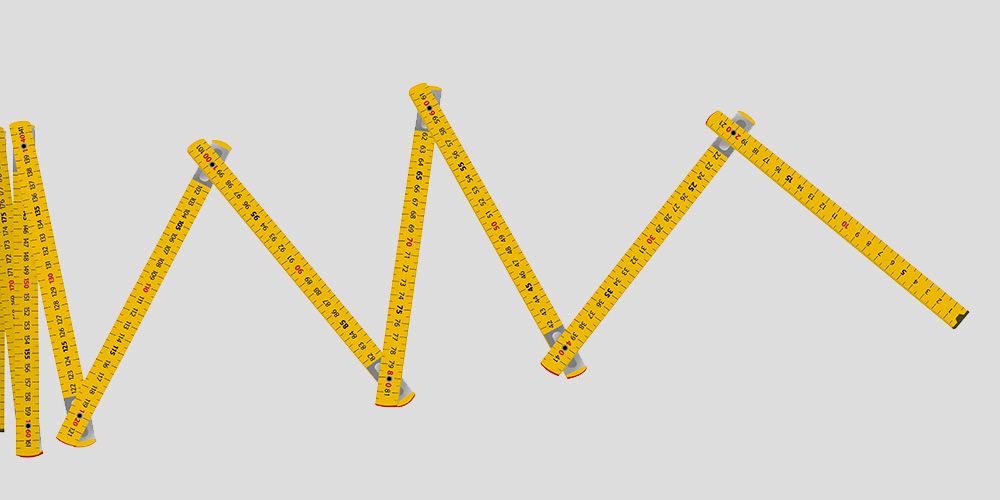

Ziehen und Rütteln am Zollstock

Ein solches Modell ist ein Zollstock, dessen einzelnen Glieder den Schichten des neuronalen Netzwerks entsprechen und den man an einem Ende auseinanderzieht. Die Nichtlinearität kommt dabei von der mechanischen Reibung zwischen den Gliedern. Ein Rauschen wiederum kann man hinzufügen, indem man beim Ziehen das Ende des Zollstocks wahllos hin und her rüttelt.

Das Ergebnis des einfachen Experiments: Zieht man langsam und gleichmässig am Zollstock, so falten sich die ersten Glieder auf, der Rest bleibt aber weitgehend zusammengefaltet. «Das entspricht einem neuronalen Netzwerk, in dem die Datenseparation hauptsächlich in den oberflächlichen Schichten passiert», erklärt Cheng Shi, Doktorand in Dokmanićs Arbeitsgruppe und Erstautor der Studie. Zieht man dagegen schnell und rüttelt dabei ein bisschen, so ist der Zollstock am Ende schön gleichmässig aufgefaltet. Bei einem Netzwerk wäre das eine gleichmässige Datenseparation.

«Wir haben ähnliche Modelle mit durch Federn verbundenen Blöcken simuliert und mathematisch analysiert, und die Übereinstimmung der Ergebnisse mit denen ‹echter› neuronaler Netzwerken ist schon fast unheimlich», sagt Shi. Die Basler Forschenden planen, ihre Methode demnächst an grossen Sprachmodellen auszuprobieren. Generell könnten solche mechanischen Modelle in Zukunft das Training von hochleistungsfähigen tiefen neuronalen Netzwerken ohne den «Versuch-und-Irrtum»-Ansatz verbessern, der traditionell angewandt wird, um die optimalen Werte von Parametern wie Nichtlinearität und Rauschen zu finden.

Originalpublikation

Cheng Shi, Liming Pan, Ivan Dokmanić

Spring-block theory of feature learning in deep neural networks.

Physical Review Letters (2025), doi: 10.1103/ys4n-2tj3